| Mówi: | dr Harish Tayyar Madabushi |

| Firma: | Uniwersytet w Bath |

Obecna technologia sztucznej inteligencji nie stanowi zagrożenia dla istnienia ludzkości. Nie jest zdolna do samodzielnego myślenia i planowania

Duże modele językowe, takie jak ChatGPT, nie potrafią samodzielnie nabywać nowych umiejętności, rozumować czy planować. Nie stanowią więc egzystencjalnego zagrożenia dla ludzkości – dowiedli naukowcy, którzy przeanalizowali możliwości dużych modeli językowych właśnie pod takim kątem. Nie oznacza to jednak, że narzędzia te nie stanowią żadnego zagrożenia. Wykorzystane niewłaściwie już dziś służą chociażby do szerzenia dezinformacji.

– Modele językowe nie stanowią zagrożenia, ponieważ nie mogą samodzielnie tworzyć planów czy strategii, które mogłyby być skierowane przeciwko nam. Kiedy korzystamy z dużego modelu językowego, takiego jak ChatGPT, mechanizm jego działania opiera się na rozwiązywaniu problemów na podstawie przykładów. Oznacza to, że nasze sugestie muszą być jasne, bardzo przejrzyste, proste, a model nie jest w stanie zrobić czegoś zupełnie odbiegającego od naszych wskazań. Jeśli nie wydamy polecenia, model nie będzie w stanie wykonać działania – informuje w wywiadzie dla agencji Newseria Innowacje dr Harish Tayyar Madabushi, wykładowca w dziedzinie sztucznej inteligencji na Uniwersytecie w Bath.

W ramach badania zrealizowanego przez naukowców z Uniwersytetu w Bath we współpracy z Uniwersytetem Technicznym w Darmstadt w Niemczech przeprowadzono eksperymenty mające na celu sprawdzenie zdolności dużych modeli językowych do wykonywania zadań, z którymi modele nigdy wcześniej się nie zetknęły. Chodziło o zweryfikowanie ich tzw. umiejętności emergentnych. Testy wyraźnie wykazały brak umiejętności złożonego rozumowania. Oznacza to, że modele – takie jakie znamy dzisiaj, ale i najprawdopodobniej te, które powstaną w przyszłości – mimo zwiększenia możliwości operacyjnych nie posiądą zdolności rozumowania i planowania.

– Trzeba jednak brać pod uwagę, że te modele mogą zostać wykorzystane w sposób, którego byśmy sobie nie życzyli. Na przykład ludzie mogą korzystać z modeli językowych, aby tworzyć bardzo dobrze skonstruowane fake newsy czy dobrze napisane wiadomości spam. Typowe wiadomości spam nie są zbyt dobrze zredagowane, więc łatwo je rozpoznać i usunąć. Teraz możemy dostawać takie wiadomości napisane nienagannym językiem. To samo dotyczy fake newsów, a generowanie takich materiałów będzie łatwiejsze. Nasze badanie ma na celu odróżnianie od siebie tych problemów. Nie musimy się martwić, że modele językowe zaczną działać niezależnie i stwarzać dla nas zagrożenie. Zamiast tego skupmy się na tym, co stanowi realne ryzyko – radzi dr Harish Tayyar Madabushi.

Niedocenianie możliwości, jakie w negatywnym kontekście stwarzają modele językowe, to jeden problem. Na drugim biegunie stoi natomiast drugi – przecenianie możliwości, jakimi dysponują narzędzia takie jak ChatGPT.

– Kiedy widzimy tekst wygenerowany przez model językowy, przypisujemy mu znaczenie, co w tym przypadku niekoniecznie jest właściwym podejściem. Tylko dlatego, że model potrafi wygenerować wypowiedź, która ma jakieś znaczenie, nie oznacza, że model przeanalizował i przyswoił to znaczenie. Przeważnie nie dysponuje on tego rodzaju informacjami, co potwierdzają nasze obserwacje. Wcale nie twierdzę, że AI nie należy się ekscytować, przeciwnie – modele językowe stanowią przełom i są zdolne do niewiarygodnych rzeczy, zwiększą wydajność w wielu dziedzinach. Jednak przecenianie tych modeli lub bezpodstawne obawy nie są właściwym podejściem do tego tematu. Myślę, że warto zwracać uwagę na pozytywne aspekty i zachować realistyczne podejście w zakresie możliwości tych modeli, żeby nie były one źródłem obaw, ale były postrzegane jako pozytywne zjawisko i ekscytujące narzędzie, z którego możemy korzystać – wskazuje badacz Uniwersytetu w Bath.

Według Polaris Market Research światowy rynek dużych modeli językowych do 2032 roku osiągnie roczne przychody w wysokości niemal 62 mld dol. przy średniorocznym tempie wzrostu wynoszącym 32 proc. W 2023 roku ten rynek był wart 5 mld dol. Analitycy podkreślają, że kluczowym czynnikiem napędzającym rozwój tego rynku w najbliższych latach będzie wprowadzenie funkcji zerowej ingerencji człowieka. Dzięki temu wzrośnie wydajność modeli i ich możliwość autonomicznego uczenia się, bez ręcznej ingerencji człowieka. Na rozwój rynku będzie też miała wpływ stale rosnąca liczba danych, na których modele mogą się uczyć.

Czytaj także

- 2025-07-11: Polskie MŚP otrzymają większe wsparcie w ekspansji międzynarodowej. To cel nowej inicjatywy sześciu instytucji

- 2025-07-16: Banki spółdzielcze coraz ważniejsze dla finansowania gospodarki. Współpraca z BGK ma pobudzić lokalne inwestycje

- 2025-07-03: Grzyby rozkładające tekstylia nagrodzone w konkursie ING. 1 mln zł trafi na innowacyjne projekty dla zrównoważonych miast

- 2025-06-10: Polska może dołączyć do globalnych liderów sztucznej inteligencji. Jednym z warunków jest wsparcie od sektora publicznego

- 2025-06-12: Nowe technologie mogą wspierać samoleczenie. Szczególnie pomocne są dane zbierane przez aplikacje i urządzenia mobilne

- 2025-07-15: Dostawy elektrykiem w centrum Warszawy. DACHSER wprowadził do Polski swój bezemisyjny program

- 2025-05-30: Konsumenci doceniają działania firm na rzecz środowiska i społeczeństwa. Dla przedsiębiorstw to szansa na rozwój

- 2025-06-12: W UE wciąż więcej kontroli działań firm w ramach ESG niż zachęt. Konieczne jest złagodzenie podejścia

- 2025-07-17: Nie tylko konsumenci starają się kupować bardziej odpowiedzialne. Część firm już stawia na to mocny nacisk

- 2025-05-27: SUV-y dominują rynek motoryzacyjny. Hyundai wprowadzi latem do sprzedaży nowy siedmioosobowy model

Więcej ważnych informacji

Jedynka Newserii

Jedynka Newserii

Jedynka Newserii

Jedynka Newserii

Ochrona środowiska

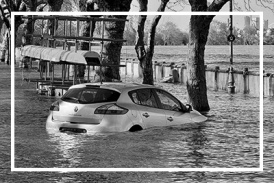

Kraje dotknięte powodzią z 2024 roku z dodatkowym wsparciem finansowym. Europosłowie wzywają do budowy w UE lepszego systemu reagowania na kryzysy

W lipcu Parlament Europejski przyjął wniosek o uruchomienie 280,7 mln euro z Funduszu Solidarności UE na wsparcie sześciu krajów dotkniętych niszczycielskimi powodziami w 2024 roku. Polska otrzyma z tego 76 mln euro, a środki mają zostać przeznaczone na naprawę infrastruktury czy miejsc dziedzictwa kulturowego. Nastroje polskich europosłów związane z funduszem są podzielone m.in. w kwestii tempa unijnej interwencji oraz związanej z nią biurokracji. Ich zdaniem w UE potrzebny jest lepszy system reagowania na sytuacje kryzysowe.

Handel

Nestlé w Polsce podsumowuje wpływ na krajową gospodarkę. Firma wygenerowała 0,6 proc. polskiego PKB [DEPESZA]

Działalność Nestlé w Polsce wsparła utrzymanie 45,2 tys. miejsc pracy i wygenerowała 20,1 mld zł wartości dodanej dla krajowej gospodarki. Firma przyczyniła się do zasilenia budżetu państwa kwotą 1,7 mld zł – wynika z „Raportu Wpływu Nestlé” w Polsce przygotowanego przez PwC na podstawie danych za 2023 rok.

Polityka

M. Kobosko: Surowce dziś rządzą światem i zdecydują o tym, kto wygra w XXI wieku. Zasoby Grenlandii w centrum zainteresowania

Duńska prezydencja w Radzie Unii Europejskiej rozpoczęła się 1 lipca pod hasłem „Silna Europa w zmieniającym się świecie”. Według zapowiedzi ma się ona skupiać m.in. na bezpieczeństwie militarnym i zielonej transformacji. Dla obu tych aspektów istotna jest kwestia niezależności w dostępie do surowców krytycznych. W tym kontekście coraz więcej mówi się o Grenlandii, autonomicznym terytorium zależnym Danii, bogatym w surowce naturalne i pierwiastki ziem rzadkich. Z tego właśnie powodu wyspa znalazła się w polu zainteresowania Donalda Trumpa.

Partner serwisu

Szkolenia

Akademia Newserii

Akademia Newserii to projekt, w ramach którego najlepsi polscy dziennikarze biznesowi, giełdowi oraz lifestylowi, a także szkoleniowcy z wieloletnim doświadczeniem dzielą się swoją wiedzą nt. pracy z mediami.

![Nestlé w Polsce podsumowuje wpływ na krajową gospodarkę. Firma wygenerowała 0,6 proc. polskiego PKB [DEPESZA]](https://www.newseria.pl/files/1097841585/fabryka-nesquik_1,w_85,r_png,_small.png)

.gif)

|

| |

| |

|