| Mówi: | dr Federico Germani |

| Firma: | Instytut Etyki Biomedycznej i Historii Medycyny, Uniwersytet Zuryski |

Fake newsy stworzone przez sztuczną inteligencję trudne do rozpoznania. Wydają się internautom bardziej wiarygodne od wiadomości tworzonych przez ludzi

Sztuczna inteligencja jest w stanie coraz lepiej imitować teksty pisane przez ludzi, a nawet tworzyć takie, które są łatwiejsze do zrozumienia – dowodzą naukowcy z Uniwersytetu Zuryskiego. Co istotne odbiorcy nie są w stanie odróżnić informacji tworzonych przez sztuczną inteligencję. Zarówno te prawdziwe, jak i fałszywe wydają im się bardziej wiarygodne niż te pisane przez ludzi. Rodzi to obawy o wykorzystanie sztucznej inteligencji do szerzenia dezinformacji.

Autorzy badania opublikowanego w „Science Advances” zwracają uwagę na to, że postęp w rozwoju generatorów SI zbiegł się z pandemią COVID-19 i trwającą wówczas infodemią, czyli natłokiem różnych informacji (w tym fałszywych). Powstały więc obawy dotyczące niewłaściwego wykorzystania sztucznej inteligencji. Generowanie i szerzenie z jej pomocą dezinformacji może mieć negatywny wpływ na wiele dziedzin życia, w tym na ochronę zdrowia na świecie. Aby sprawdzić, jak tekst stworzony przez SI może wpłynąć na zrozumienie informacji przez odbiorców, naukowcy przyjrzeli się tweetom wytwarzanym przez GPT-3.

Badacze wygenerowali za pomocą GPT-3 tweety zawierające informacje lub dezinformacje na różne tematy, w tym dotyczące szczepionek, technologii 5G, COVID-19 i teorii ewolucji. Zestawili je z wiadomościami napisanymi przez ludzi. Następnie stworzyli ankietę i poprosili o jej wypełnienie ok. 700 respondentów z kilku krajów, w wieku średnio od 42 do 72 lat, o podobnym wykształceniu. Pierwszym pytaniem było to, czy dany tweet wygląda na syntetyczny (wygenerowany przez GPT-3), czy organiczny (stworzony przez człowieka). W drugim użytkownicy oceniali, czy informacje zawarte w tweecie były prawdziwe, czy nieprawdziwe pod względem naukowym.

– Informacje wygenerowane przez sztuczną inteligencję były dla respondentów bardziej przekonujące. Ludzie oceniali lepiej prawdziwość informacji wytworzonych przez SI w porównaniu do tych stworzonych przez człowieka. Poza tym ankietowani mieli tendencję do ufania w większym stopniu nieprawdziwym informacjom wygenerowanym przez SI w porównaniu do tych pochodzących od ludzi. Sprawia to, że GPT jest swego rodzaju mieczem obusiecznym, ponieważ ma on potencjalnie pozytywne zastosowania w praktyce, przy jednoczesnej możliwości negatywnych zastosowań do generowania przekonujących fałszywych informacji – mówi agencji Newseria Innowacje dr Federico Germani z Instytutu Etyki Biomedycznej i Historii Medycyny Uniwersytetu Zuryskiego.

Autorzy badania przeanalizowali też potencjał sztucznej inteligencji do identyfikowania dezinformacji. Poprosili GPT-3 o ocenę, które z tweetów są prawdziwe, a które wprowadzają w błąd. SI, podobnie jak respondenci, miał większe trudności z oceną dokładności informacji.

– Zgodnie z wynikami naszego badania nie ma możliwości rozróżnienia pomiędzy informacjami pochodzącymi od człowieka a tymi wygenerowanymi przez GPT-3. Możliwe, że ludzie, którzy opanowują tę technologię i korzystają z niej codziennie, będą mogli rozpoznać różnicę. Jednak nie jest to szczególnie istotne, ponieważ w perspektywie średnio- i długoterminowej w miarę rozwoju nowych modeli i tak nie będziemy w stanie rozróżnić tekstu stworzonego przez człowieka i przez sztuczną inteligencję – ocenia dr Federico Germani.

Naukowcy proponują zmianę dotychczasowego podejścia do modelu skutecznej komunikacji i oceny informacji, zgodnie z którym człowiek wytwarza informacje, a sztuczna inteligencja pomaga w ich ocenie. Są zdania, że dobrze skrojoną kampanię informacyjną można stworzyć, przekazując wskazówki do SI, która jest w stanie lepiej niż człowiek napisać łatwiejsze w odbiorze teksty, ale dokładność wygenerowanych przez nią informacji powinna być sprawdzona przez przeszkolonych ludzi. Ten model komunikacji może mieć szczególne znaczenie w sytuacji, w której potrzeba jasnej i szybkiej komunikacji z dużymi grupami społeczeństwa.

– Jest to jedno z pierwszych opracowań wskazujących na problem sztucznej inteligencji w kontekście dezinformacji. Warto zaznaczyć, że nasze badanie odbywa się w warunkach doświadczalnych, a nie rzeczywistych, dlatego jest ono ważne dla rozumienia wpływu fałszywych informacji generowanych przez SI na społeczeństwo poprzez obserwację obiegu nieprawdziwych informacji wytworzonych przez SI w mediach społecznościowych i reakcji ludzi na nie. Kolejnym etapem będzie rozumienie wpływu tego zjawiska na zachowania poszczególnych osób oraz na zdrowie jednostek i zdrowie publiczne. Jest to bardzo istotny nowy kierunek badań interakcji ludzi z informacjami w całkowicie nowym otoczeniu sterowanym przez sztuczną inteligencję – podkreśla badacz Uniwersytetu w Zurychu.

Podobne wnioski przedstawiają w swoim raporcie naukowcy z Georgetown University i Obserwatorium Internetu przy Uniwersytecie Stanforda, którzy po przeanalizowaniu możliwości zastosowań SI do szerzenia dezinformacji uważają, że propaganda z wykorzystaniem algorytmów będzie się nasilać. Przygotowanie społeczeństwa do właściwego odbioru informacji jest równie ważne, co współpraca między twórcami SI i platformami mediów społecznościowych, kontrola dostępu do sprzętu i technologii służących do budowy SI czy np. konieczność oznaczania treści wygenerowanych przez algorytm.

– Mamy do czynienia z nadmierną liczbą informacji, które są dostępne dla każdego do oceny, a wśród nich znajduje się sporo fałszywych informacji. Przy wykorzystaniu sztucznej inteligencji liczba fałszywych i prawdziwych informacji prawdopodobnie wzrośnie. Nie możemy myśleć, że mamy nad tym kontrolę – mówi dr Federico Germani. – W czasie pandemii COVID-19 przekonaliśmy się, że cenzura jest narzędziem, które może zostać wykorzystane do ograniczenia fałszywych informacji, ale jest to rozwiązanie mające pozytywne skutki w krótkiej perspektywie czasowej. W perspektywie średnio- i długoterminowej jest ona szkodliwa, prowadząc na przykład do ograniczonego zaufania wobec instytucji opieki zdrowotnej wydających zalecenia w zakresie zdrowia publicznego do przestrzegania w sytuacji kryzysowej. Dlatego musimy znaleźć inne strategie.

Zdaniem badacza jedyną szansą skutecznej walki z dezinformacją jest edukacja medialna odbiorców, aby na podstawie określonych cech danej wiadomości mogli ocenić, czy jest ona prawdziwa, czy też nie.

W polskiej infosferze w celu wypracowania standardów walki z dezinformacją powstał Kodeks Dobrych Praktyk opublikowany przez NASK. Jest on skierowany zarówno do dziennikarzy, osób publicznych, jak i do odbiorców. Zawarte w nim wskazówki pomagają zrozumieć procesy dezinformacyjne, rozpoznawać szkodliwe treści i zapobiegać ich rozpowszechnianiu.

Czytaj także

- 2025-06-10: Polska może dołączyć do globalnych liderów sztucznej inteligencji. Jednym z warunków jest wsparcie od sektora publicznego

- 2025-06-12: Nowe technologie mogą wspierać samoleczenie. Szczególnie pomocne są dane zbierane przez aplikacje i urządzenia mobilne

- 2025-05-27: SUV-y dominują rynek motoryzacyjny. Hyundai wprowadzi latem do sprzedaży nowy siedmioosobowy model

- 2025-05-28: Interakcja z firmą jest dla klientów równie ważna jak jej produkty. Biznes wykorzystuje do tego AI

- 2025-05-02: Im bliżej wyborów prezydenckich, tym więcej dezinformacji. Polacy nie umieją jeszcze jej rozpoznawać

- 2025-07-23: Branża pomp ciepła w Polsce odczuwa konsekwencje dezinformacji. Krążące mity zniechęcają do tej technologii

- 2025-04-14: Nowe technologie podstawą w reformowaniu administracji. Będą też kluczowe w procesie deregulacji

- 2025-04-15: Obciążenia regulacyjne uderzają w branżę nowych technologii i start-upy. To może hamować innowacje

- 2025-04-16: Sztuczna inteligencja napędza innowacje, ale pochłania ogromne ilości prądu. Rośnie potrzeba bardziej energooszczędnych rozwiązań

- 2025-03-03: Unia Europejska spóźniona w wyścigu AI. Eksperci apelują o szybsze inwestycje i zaprzestanie regulacji

Więcej ważnych informacji

Jedynka Newserii

Jedynka Newserii

Jedynka Newserii

Jedynka Newserii

Ochrona środowiska

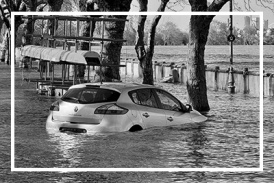

Kraje dotknięte powodzią z 2024 roku z dodatkowym wsparciem finansowym. Europosłowie wzywają do budowy w UE lepszego systemu reagowania na kryzysy

W lipcu Parlament Europejski przyjął wniosek o uruchomienie 280,7 mln euro z Funduszu Solidarności UE na wsparcie sześciu krajów dotkniętych niszczycielskimi powodziami w 2024 roku. Polska otrzyma z tego 76 mln euro, a środki mają zostać przeznaczone na naprawę infrastruktury czy miejsc dziedzictwa kulturowego. Nastroje polskich europosłów związane z funduszem są podzielone m.in. w kwestii tempa unijnej interwencji oraz związanej z nią biurokracji. Ich zdaniem w UE potrzebny jest lepszy system reagowania na sytuacje kryzysowe.

Handel

Nestlé w Polsce podsumowuje wpływ na krajową gospodarkę. Firma wygenerowała 0,6 proc. polskiego PKB [DEPESZA]

Działalność Nestlé w Polsce wsparła utrzymanie 45,2 tys. miejsc pracy i wygenerowała 20,1 mld zł wartości dodanej dla krajowej gospodarki. Firma przyczyniła się do zasilenia budżetu państwa kwotą 1,7 mld zł – wynika z „Raportu Wpływu Nestlé” w Polsce przygotowanego przez PwC na podstawie danych za 2023 rok.

Polityka

M. Kobosko: Surowce dziś rządzą światem i zdecydują o tym, kto wygra w XXI wieku. Zasoby Grenlandii w centrum zainteresowania

Duńska prezydencja w Radzie Unii Europejskiej rozpoczęła się 1 lipca pod hasłem „Silna Europa w zmieniającym się świecie”. Według zapowiedzi ma się ona skupiać m.in. na bezpieczeństwie militarnym i zielonej transformacji. Dla obu tych aspektów istotna jest kwestia niezależności w dostępie do surowców krytycznych. W tym kontekście coraz więcej mówi się o Grenlandii, autonomicznym terytorium zależnym Danii, bogatym w surowce naturalne i pierwiastki ziem rzadkich. Z tego właśnie powodu wyspa znalazła się w polu zainteresowania Donalda Trumpa.

Partner serwisu

Szkolenia

Akademia Newserii

Akademia Newserii to projekt, w ramach którego najlepsi polscy dziennikarze biznesowi, giełdowi oraz lifestylowi, a także szkoleniowcy z wieloletnim doświadczeniem dzielą się swoją wiedzą nt. pracy z mediami.

![Nestlé w Polsce podsumowuje wpływ na krajową gospodarkę. Firma wygenerowała 0,6 proc. polskiego PKB [DEPESZA]](https://www.newseria.pl/files/1097841585/fabryka-nesquik_1,w_85,r_png,_small.png)

.gif)

|

| |

| |

|